L'architecture des applications segmentées révolutionne la façon dont les entreprises conçoivent, développent et déploient leurs logiciels. Cette approche modulaire offre une flexibilité et une évolutivité sans précédent, permettant aux organisations de s'adapter rapidement aux changements du marché. En décomposant les applications en composants indépendants, les équipes de développement peuvent travailler de manière plus agile et déployer des mises à jour avec une fréquence accrue. Cependant, la transition vers une architecture segmentée soulève également de nouveaux défis en termes de gestion de la complexité, de sécurité et de performance.

Architecture des applications segmentées : principes et composants clés

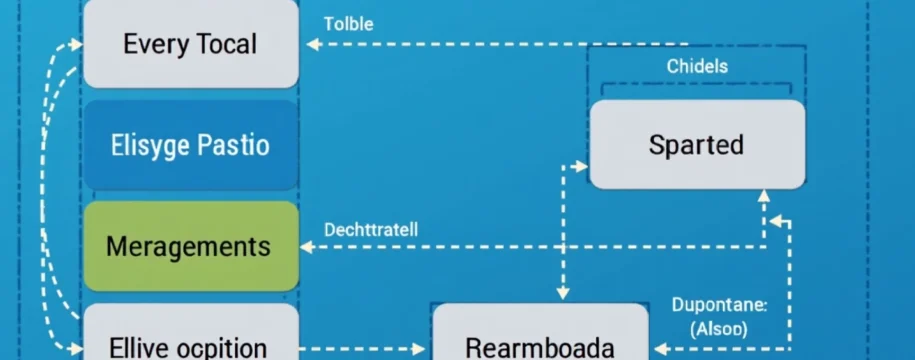

L'architecture des applications segmentées repose sur le principe de la décomposition fonctionnelle. Plutôt que de construire une application monolithique, on divise le système en services autonomes, chacun responsable d'une fonction métier spécifique. Ces services communiquent entre eux via des APIs bien définies, généralement en utilisant des protocoles légers comme HTTP/REST ou gRPC.

Les composants clés d'une architecture segmentée incluent :

- Microservices : Services indépendants et faiblement couplés

- API Gateway : Point d'entrée unique pour les requêtes clients

- Service Registry : Annuaire centralisant les informations sur les services disponibles

- Load Balancer : Répartition de la charge entre les instances de services

- Message Broker : Gestion de la communication asynchrone entre services

Cette approche modulaire offre de nombreux avantages. Elle permet notamment une meilleure isolation des composants , facilitant ainsi les mises à jour et les tests. De plus, elle favorise l'évolutivité horizontale , permettant d'augmenter les capacités du système en ajoutant simplement de nouvelles instances de services.

Microservices vs monolithes : analyse comparative pour applications segmentées

Le débat entre architectures microservices et monolithiques est au cœur des discussions sur la conception d'applications modernes. Chaque approche présente ses propres avantages et inconvénients, qu'il convient d'analyser en fonction du contexte spécifique de chaque projet.

Avantages des microservices dans le développement modulaire

Les microservices offrent une flexibilité inégalée dans le développement d'applications complexes. En décomposant l'application en services indépendants, les équipes peuvent travailler en parallèle sur différents composants, accélérant ainsi le cycle de développement. Cette approche facilite également l'adoption de nouvelles technologies, chaque service pouvant être développé avec le langage ou le framework le plus adapté à sa fonction.

Un autre avantage majeur des microservices réside dans leur résilience accrue . La défaillance d'un service n'entraîne pas nécessairement l'arrêt de l'ensemble du système, contrairement à une application monolithique. De plus, la scalabilité fine permise par les microservices permet d'optimiser l'utilisation des ressources en augmentant uniquement la capacité des services sous pression.

Défis de la migration d'un monolithe vers une architecture segmentée

La transition d'une architecture monolithique vers des microservices n'est pas sans difficultés. L'un des principaux défis réside dans la gestion de la complexité accrue du système distribué. La multiplication des services nécessite la mise en place d'une infrastructure robuste pour gérer la communication inter-services, le monitoring et le déploiement.

La refactorisation du code existant peut également s'avérer complexe, notamment pour identifier les bonnes frontières entre les services. Une décomposition mal pensée peut entraîner des problèmes de performance dus à une communication excessive entre les services. De plus, la gestion de la cohérence des données dans un système distribué soulève de nouveaux défis en termes de transactions et de synchronisation.

Étude de cas : refactorisation de netflix vers une architecture microservices

Netflix est souvent cité comme un exemple emblématique de migration réussie vers une architecture microservices. Confrontée à des problèmes de scalabilité avec son infrastructure monolithique, l'entreprise a entamé en 2009 un processus de refactorisation progressive de son application.

Cette transition s'est étalée sur plusieurs années, impliquant la décomposition minutieuse de l'application en centaines de microservices. Netflix a développé et open-sourcé de nombreux outils pour gérer cette architecture complexe, comme Eureka pour la découverte de services ou Hystrix pour la gestion des défaillances.

La migration vers les microservices a permis à Netflix de passer d'un déploiement bi-mensuel à des milliers de déploiements par jour, illustrant l'agilité exceptionnelle offerte par cette architecture.

Technologies et outils pour le développement d'applications segmentées

Le développement d'applications segmentées s'appuie sur un écosystème riche d'outils et de technologies. Ces solutions facilitent la création, le déploiement et la gestion des architectures distribuées modernes.

Frameworks de microservices : spring boot, express.js, flask

Les frameworks de microservices jouent un rôle crucial dans le développement d'applications segmentées. Ils fournissent les briques de base nécessaires pour créer rapidement des services robustes et évolutifs. Parmi les options populaires :

- Spring Boot : Framework Java offrant une configuration automatique puissante

- Express.js : Framework minimaliste pour Node.js, idéal pour des API légères

- Flask : Micro-framework Python flexible et facile à prendre en main

Ces frameworks simplifient de nombreux aspects du développement, comme la gestion des dépendances, la configuration ou l'exposition d'APIs REST. Ils permettent aux développeurs de se concentrer sur la logique métier plutôt que sur les détails d'infrastructure.

Conteneurisation avec docker pour le déploiement d'applications modulaires

La conteneurisation est devenue un élément incontournable des architectures microservices. Docker, en particulier, s'est imposé comme la solution de référence pour l'empaquetage et le déploiement d'applications conteneurisées.

L'utilisation de conteneurs offre plusieurs avantages majeurs :

- Portabilité : Les conteneurs encapsulent l'application et ses dépendances, garantissant un comportement cohérent dans différents environnements

- Isolation : Chaque service s'exécute dans son propre conteneur, limitant les conflits de dépendances

- Efficacité : Les conteneurs sont légers et démarrent rapidement, optimisant l'utilisation des ressources

La conteneurisation facilite également la mise en œuvre de pratiques DevOps comme l'intégration et le déploiement continus (CI/CD), en standardisant le processus de déploiement des applications.

Orchestration de services avec kubernetes dans les architectures segmentées

Kubernetes s'est imposé comme la plateforme d'orchestration de conteneurs dominante pour les architectures microservices. Elle automatise le déploiement, la mise à l'échelle et la gestion des applications conteneurisées, simplifiant considérablement l'exploitation d'infrastructures complexes.

Parmi les fonctionnalités clés de Kubernetes pour les applications segmentées :

- Auto-scaling : Ajustement automatique du nombre d'instances de services en fonction de la charge

- Service discovery : Localisation dynamique des services au sein du cluster

- Rolling updates : Mises à jour progressives sans interruption de service

- Self-healing : Redémarrage automatique des conteneurs défaillants

L'utilisation de Kubernetes permet aux équipes de se concentrer sur le développement des fonctionnalités métier, en déléguant la gestion complexe de l'infrastructure à la plateforme.

API gateway : gestion des requêtes dans les applications distribuées

L'API Gateway joue un rôle central dans les architectures microservices en agissant comme point d'entrée unique pour les requêtes clients. Elle offre plusieurs fonctionnalités essentielles :

- Routage : Redirection des requêtes vers les services appropriés

- Agrégation : Composition de réponses à partir de plusieurs services

- Authentification : Vérification centralisée des identités et des autorisations

- Rate limiting : Protection contre les surcharges de requêtes

Des solutions comme Kong, Apigee ou AWS API Gateway offrent des fonctionnalités avancées pour la gestion des API dans les architectures distribuées. Elles permettent de simplifier la complexité inhérente aux systèmes microservices pour les clients externes.

Sécurité et performance des applications segmentées

La sécurisation et l'optimisation des performances des applications segmentées présentent des défis spécifiques liés à leur nature distribuée. Une approche holistique est nécessaire pour garantir la robustesse et l'efficacité de ces systèmes complexes.

Implémentation de l'authentification distribuée avec OAuth 2.0 et JWT

Dans une architecture microservices, la gestion de l'authentification et de l'autorisation doit être repensée pour s'adapter à un environnement distribué. L'utilisation combinée d'OAuth 2.0 pour le flux d'autorisation et de JSON Web Tokens (JWT) pour la transmission sécurisée des informations d'identité s'est imposée comme une pratique standard.

Cette approche offre plusieurs avantages :

- Stateless : Les tokens JWT contiennent toutes les informations nécessaires, évitant le besoin de stocker des sessions côté serveur

- Scalabilité : L'authentification peut être vérifiée par chaque service indépendamment

- Flexibilité : Support de différents types de clients (web, mobile, IoT)

L'implémentation d'une solution d'authentification robuste nécessite une attention particulière à la sécurité des tokens, notamment leur durée de validité et leur stockage côté client.

Monitoring et logging : utilisation d'ELK stack pour applications segmentées

La visibilité sur le fonctionnement d'une application distribuée est cruciale pour en assurer la fiabilité et les performances. L'ELK Stack (Elasticsearch, Logstash, Kibana) s'est imposé comme une solution de choix pour le monitoring et l'analyse de logs dans les architectures microservices.

Cette stack offre plusieurs fonctionnalités essentielles :

- Collecte centralisée : Agrégation des logs de tous les services

- Recherche temps réel : Indexation puissante pour des requêtes rapides

- Visualisation : Tableaux de bord personnalisables pour suivre les KPIs

- Alerting : Détection proactive des anomalies

L'utilisation de l'ELK Stack permet aux équipes d'obtenir une vue d'ensemble du système, facilitant le diagnostic des problèmes et l'optimisation des performances.

Optimisation des performances : caching distribuée avec redis

La gestion du caching dans une architecture distribuée est essentielle pour optimiser les performances et réduire la charge sur les services backend. Redis, une base de données in-memory, est largement utilisée comme solution de caching distribuée dans les architectures microservices.

Redis offre plusieurs avantages pour le caching distribué :

- Performances élevées : Stockage en mémoire pour des temps d'accès ultra-rapides

- Structures de données variées : Support de types complexes au-delà des simples paires clé-valeur

- Persistence : Option de sauvegarde sur disque pour la durabilité des données

- Scalabilité : Possibilité de clustering pour une mise à l'échelle horizontale

L'utilisation judicieuse du caching peut considérablement améliorer les temps de réponse et réduire la charge sur les bases de données, contribuant ainsi à la scalabilité globale du système.

Patterns de conception pour applications segmentées efficaces

La conception d'applications segmentées robustes et évolutives s'appuie sur des patterns éprouvés. Ces modèles de conception résolvent des problématiques récurrentes dans les architectures distribuées, comme la gestion des défaillances ou la communication entre services.

Circuit breaker pattern : gestion des défaillances avec hystrix

Le pattern Circuit Breaker est essentiel pour améliorer la résilience des applications distribuées. Il permet de gérer élégamment les défaillances de services en évitant les effets cascade. Hystrix, développé par Netflix, est une implémentation populaire de ce pattern pour les architectures microservices.

Le fonctionnement du Circuit Breaker se décompose en trois états :

- Fermé : Les requêtes sont transmises normalement au service

- Ouvert : Les requêtes sont immédiatement rejetées sans appeler le service défaillant

- Semi-ouvert : Un nombre limité de requêtes est autorisé pour tester la disponibilité du service

Hystrix offre des fonctionnalités avancées comme la définition de timeouts, la mise en place de fallbacks, ou encore le monitoring en temps réel des circuits. Son utilisation permet d'éviter la propagation des défaillances et d'améliorer la stabilité globale du système.

Event-driven architecture : utilisation de apache kafka pour la communication inter-services

L'architecture event-driven est particulièrement adaptée aux systèmes distribués, permettant un découplage fort entre les services. Apache Kafka s'est imposé comme une plateforme de streaming distribuée de référence pour implémenter ce pattern dans les architectures microservices.

Kafka offre plusieurs avantages clés :

- Scalabilité : Capable de gérer des millions d'événements par seconde

L'utilisation de Kafka comme bus d'événements facilite la communication asynchrone entre services, améliorant ainsi la réactivité et la résilience du système. Elle permet également de mettre en place des architectures basées sur le Event Sourcing, où l'état du système est dérivé de la séquence des événements.

CQRS et event sourcing dans les architectures microservices

Les patterns CQRS (Command Query Responsibility Segregation) et Event Sourcing sont souvent utilisés conjointement dans les architectures microservices pour gérer la complexité des modèles de données et améliorer les performances.

Le CQRS sépare les opérations de lecture (queries) des opérations d'écriture (commands), permettant d'optimiser chaque modèle indépendamment. L'Event Sourcing, quant à lui, consiste à stocker l'état d'une application sous forme d'une séquence d'événements plutôt que sous forme d'instantanés.

Ces patterns offrent plusieurs avantages dans un contexte microservices :

- Scalabilité : Les modèles de lecture et d'écriture peuvent être mis à l'échelle séparément

- Flexibilité : Possibilité de reconstruire l'état du système à n'importe quel point dans le temps

- Audit : Historique complet des changements d'état

- Performance : Optimisation des requêtes de lecture complexes

Cependant, la mise en œuvre de CQRS et Event Sourcing peut complexifier l'architecture et nécessite une gestion minutieuse de la cohérence éventuelle entre les modèles de lecture et d'écriture.

Déploiement et gestion du cycle de vie des applications segmentées

Le déploiement et la gestion du cycle de vie des applications segmentées nécessitent des approches adaptées à la nature distribuée de ces systèmes. L'automatisation et les pratiques DevOps jouent un rôle crucial dans la gestion efficace de ces architectures complexes.

CI/CD pour applications segmentées : jenkins, GitLab CI, et GitHub actions

L'intégration continue et le déploiement continu (CI/CD) sont essentiels pour maintenir la qualité et la rapidité de livraison des applications segmentées. Plusieurs outils populaires facilitent la mise en place de pipelines CI/CD robustes :

- Jenkins : Serveur d'automatisation open-source hautement personnalisable

- GitLab CI : Solution intégrée de gestion de code et de CI/CD

- GitHub Actions : Outil d'automatisation intégré à GitHub

Ces plateformes permettent d'automatiser les tests, la construction et le déploiement de chaque microservice indépendamment. Elles favorisent également l'adoption de pratiques comme le déploiement fréquent et les tests automatisés, essentiels pour maintenir la stabilité d'un système distribué.

Blue-green deployment et canary releases pour mises à jour sans interruption

Les stratégies de déploiement blue-green et canary sont particulièrement adaptées aux architectures microservices, permettant des mises à jour avec un risque minimal d'interruption de service.

Le déploiement blue-green consiste à maintenir deux environnements identiques (blue et green) et à basculer le trafic de l'un à l'autre lors des mises à jour. Cette approche permet un rollback rapide en cas de problème.

Les canary releases, quant à elles, consistent à déployer progressivement une nouvelle version à un sous-ensemble limité d'utilisateurs. Cela permet de tester la nouvelle version en conditions réelles tout en limitant l'impact potentiel des problèmes.

Ces stratégies offrent plusieurs avantages :

- Réduction des temps d'indisponibilité

- Possibilité de tests en production

- Rollback rapide en cas de problème

- Réduction du risque lors des déploiements

Gestion de la configuration avec consul et etcd

La gestion de la configuration est un défi majeur dans les architectures microservices, où chaque service peut avoir ses propres paramètres de configuration. Des outils comme Consul et etcd facilitent la gestion centralisée de la configuration dans un environnement distribué.

Consul, développé par HashiCorp, offre des fonctionnalités de stockage de configuration, de découverte de services et de gestion de santé. etcd, quant à lui, est un magasin de clés-valeurs distribué, souvent utilisé comme backend de configuration pour Kubernetes.

Ces outils permettent :

- La centralisation de la configuration des services

- La mise à jour dynamique de la configuration sans redémarrage des services

- La gestion des secrets de manière sécurisée

- La cohérence de la configuration dans un environnement multi-instances

L'utilisation d'outils de gestion de configuration comme Consul ou etcd simplifie considérablement l'exploitation d'architectures microservices complexes, en assurant que chaque service dispose toujours des paramètres les plus à jour.